#ResearchHighlight

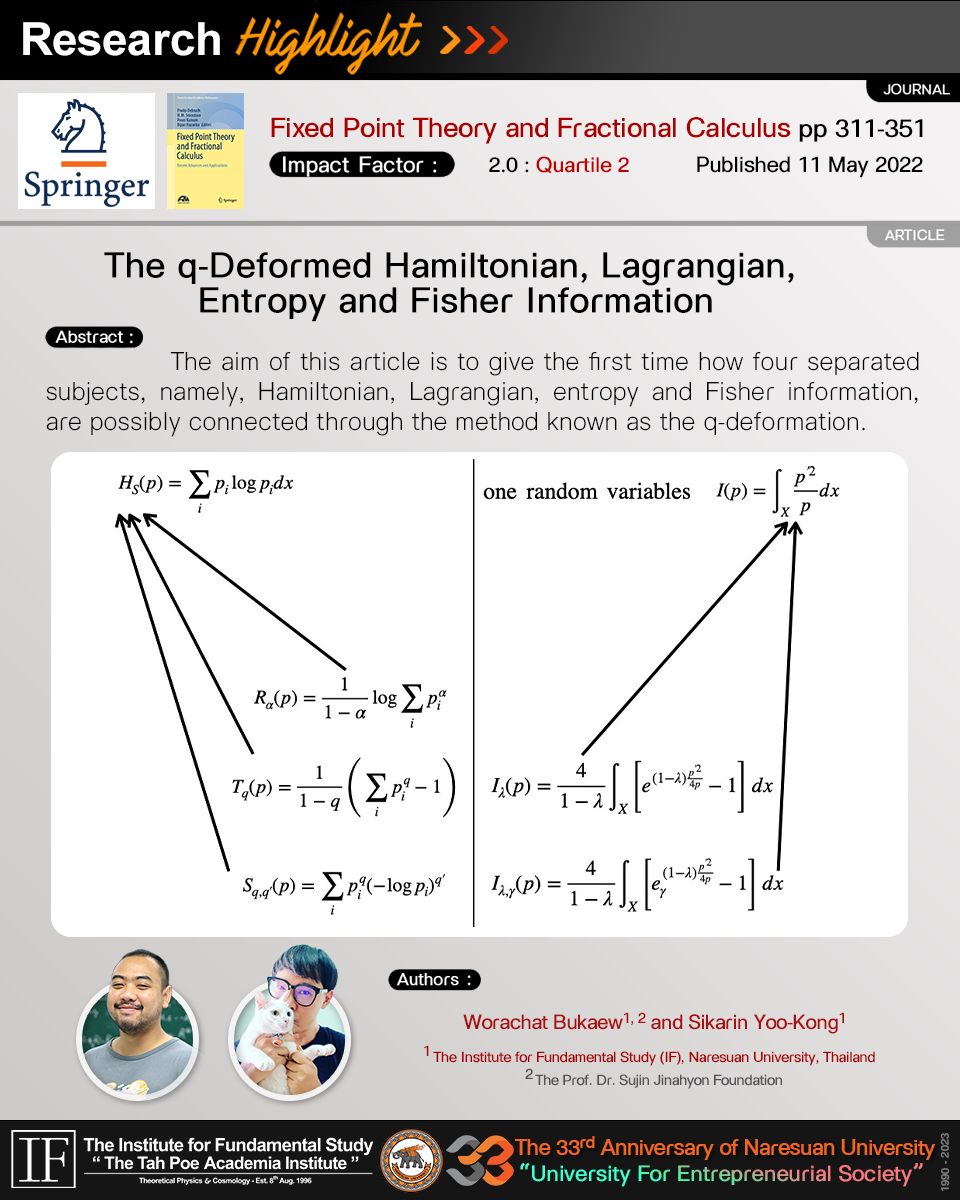

🛎 The q-Deformed Hamiltonian, Lagrangian, Entropy and Fisher Information

📌 Authors: Worachat Bukaew (IF, Naresuan Univ., Thailand) and Sikarin Yoo-Kong (IF, Naresuan Univ., Thailand)

📌 ความสำคัญและที่มา

เอนโทรปีนั้นเป็นปริมาณพื้นฐานที่สำคัญอันหนึ่งในฟิสิกส์ซึ่งจุดเริ่มต้นกำเนิดมาจากอุณหพลศาสตร์จากนั้นแนวคิดได้ขยายไปยังกลศาสตร์เชิงสถิติแบบคลาสสิค ปริมาณเอนโทรปีที่รู้จักกันดีในฟิสิกส์คือ กิ๊บ-บ็อลทซ์มันเอนโทรปี นอกจากนัั้นแล้วปริมาณเอนโทรปียังไปมีบทบาทสำคัญในทฤษฎีการสื่อสารซึ่งรู้จักกันในชื่อ แชนนอนเอนโทรปี แน่นอนว่าไม่ว่าจะเป็น กิ๊บ-บ็อลทซ์มัน หรือ แชนนอนเอนโทรปี นั้นอยู่ในรูปของการหาค่าเฉลื่ยเชิงเส้นของปริมาณที่แชนนอนเรียกว่า เซอร์ไพรส์ซัล(ความประหลาดใจ หรือ อินฟอร์เมชัน) เรนยีเริ่มตั้งคำถามว่า จะมีรูปของเอนโทรปีในรูปแบบอื่นมั้ยโดยที่ยังมีสมบัติพื้นฐานทางคณิตศาสตร์เหมือนเดิม และเขาก็พบว่ามีแต่เรนยีเอนโทรปีนั้นมาพร้อมกับพารามิเตอร์ 1 ตัว โดยที่หากพิจารณาลิมิตสำหรับพารามิเตอร์นี้ แชนนอน-กิ๊บ-บ็อลทซ์มันเอนโทรปี นอกจากนั้นแล้วซาลลิสได้นำเสนอเอนโทรปีรูปแบบใหม่สำหรับระบบที่มีคอลลีเรชันกันภายในและประเด็นที่น่าสนใจคือ ซาลลิสเอนโทรปีนี้มาพร้อมกับพารามิเตอร์เหมือนกัน และที่น่าสนใจไปกว่านั้นคือ ซาลลิสเอนโทรปีนั้นมีโครงสร้างเกี่ยวข้องโดยตรงกับทฤษฎีคณิตศาสตร์ที่เรียกว่า แฟลกชันนัลแคลคูลัสหรือย่อยลงมาในบริบท q-ดีฟอร์เมชันสำหรับอนุพันธ์และปริพันธ์อีกทั้งฟังก์ชันทางคณิตศาสตร์อื่นๆ เช่น ฟังก์ชันเอ็กโปเนนเชียล เป็นต้น และภายใต้การพิจารณาลิมิตที่เหมาะสมของพารามิเตอร์ q เราจะได้รูปแบบมาตรฐานของทุกอย่างกลับมา

สำหรับในแง่ของกลศาสตร์ลากรองจ์และฮามิลตันนั้นได้มีการค้นพบรูปแบบการเขียนลากรางเจียนแบบใหม่สำหรับหรับกรณีระบบทีี่มี 1 ตัวแปรเรียกว่า ลากรางเจียนผลคูณซึ่งมาพร้อมกับพารามิเตอร์ และภายใต้การพิจารณาลิมิตที่เหมาะสมของพารามิเตอร์จะให้ลากรางเจียนรูปแบบมาตรฐาน แน่นอนว่าเราสามารถทำการหาฮามิลโตเนียนที่สอดคล้องกับลากรางเจียนผลคูณได้ สิ่งข้อสังเกตที่น่าสนใจซึ่งได้ชี้ไว้ในงานชิ้นนี้คือ เราสามารถเขียนฮามิลโตเนียนผลคูณนี้ให้อยู่ในรูปแบบเดียวกันแบบซอลลิสเอนโทรปี(แต่ไม่ได้บอกว่าปริมาณทั้ง 2 นั้นสัมพันธ์กัน)

นอกจากปริมาณเอนโทรปีที่ใช่ในการวัดปริมาณอินฟอร์เมชันของระบบแล้วเรายังมีปริมาณที่เรียกว่า ฟิชเชอร์อินฟอร์เมชัน ซึ่งมองได้ว่าหากปริมาณเอนโทรปีนั้นอธิบายการวิวัฒน์ของระบบเชิงสถิติ ฟิชเชอร์นั้นมีเอาไว้ดูโครงสร้างภายในของระบบ ดังนั้นการที่เรารู้ทั้ง 2 ปริมาณสำหรับระบบใดๆจะทำให้เราสามารถศึกษาระบบได้อย่างสมบูรณ์แบบมากขึ้น ทั้งนี้มีหลายคนพยายามสร้างฟิชเชอร์อินฟอร์เมชันที่มีพารามิเตอร์หลากหลายรูปแบบขึ้นอยู่กับวัถตุการนำไปใช้เชิงสถิติ(ตรงนี้เทียบกับการที่เรามีเรนยีเอนโทรปีหรือซอลลิสเอนโทรปี) ในการศีกษาของเรานี้นั้นเราสร้างฟิชเชอร์อินฟอร์เมชันสำหรับกรณีตัวแปรสุ่ม 1 ตัวและตัวแปรที่ต้องการประมาณ 1 ตัวจากการอาศัยมุมมองความเชื่อมโยงระหว่างฟิชเชอร์อินฟอร์เมชันกับแอคชันฟังก์ชันนัลและลากรางเจียนผลคูณ แน่นอนว่าฟิชเชอร์อินฟอร์เมชันที่ได้ออกมานั้นจะมีพารามิเตอร์ 1 ตัวและเมื่อทำการพิจารณาลิมิตที่เหมาะสมจะได้ฟิชเชอร์อินฟอร์เมชันมาตรฐานกลับมา ประเด็นที่น่าสนใจคือ หากเราทำการกระจายอนุกรมของฟิชเชอร์เทียบกับพารามิเตอร์เราจะได้ชุดของฟิชเชอร์อินฟอร์เมชัน(หรือเรียกว่า ไฮอะราคี) โดยมีฟิชเชอร์อินฟอร์เมชันมาตรฐานเป็นตัวแรกในไฮอะราคี ความน่าสนใจเชิงรูปคณิตศาสตร์คือ ฟิชเชอร์อินฟอร์เมชันใหม่นี้สามารถเขียนได้เหมือนกันกับซอลลิสเอนโทรปีและแน่นอนว่าสมบัติของการบวกยอมไม่เป็นจริงตามไปด้วย อย่างไรก็ดีในแง่ของการนำไปประยุกต์ใช่นั้นยังคงเป็นปัญหาปลายเปิด

📌 ผลสัมฤทธิ์สำคัญ

– นำเสนอแนวทางการสร้างลากรางเจียนและฮามิลโตเนียนแบบใหม่ที่มีพารามิเตอร์หลายตัวผ่านแนวคิดของการแก้ปัญหาย้อนกลับของแคลคูลัสของการแปรผัน

– สรุปภาพรวมแนวคิดของเอนโทรปีที่มีอยู่หลากหลาย

– สร้างฟิชเชอร์อินฟอร์เมชันสำหรับกรณี 1 พารามิเตอร์ของระบบที่มีตัว 1 ตัวแปรสุ่มและ 1 ตัวแปรคาดคะเน อีกทั้งยังชี้ประเด็นโครงสร้างและสมบัติทางคณิตศาสตร์ที่อาจมีความเชื่อมโยงไปยังซอลลิสเอนโทรปี

📌 Motivation and background

Entropy is one of the fundamental quantities in physics and its originality can be tracked back to thermodynamics and later the idea was extended to the classical statistical mechanics. In this context, the entropy is named as the Gibbs-Boltzmann entropy. In the communication context, the entropy also plays an important role and is known as the Shannon entropy. The Shannon entropy can be viewed as a linear average of the surprisal (information). Later, Renyi gives an alternative form of the entropy which is not in the form of the linear average of the surprisal. The point is that Renyi entropy comes with a parameter and with an appropriate limit on the parameter, the Shannon entropy is recovered. Furthermore, the Renyi entropy follows the same mathematical properties with the Gibbs-Boltzmann entropy, e.g. additive property. Another entropy, called the Tsallis entropy, was constructed to explain the system with internal correlations. An interesting point is that the Tsallis entropy possesses a mathematical structure known as the fractional calculus, or more precise, the q-deformation for differentiation and integration. Of course, under the appropriate limit, the Gibbs-Boltzmann entropy is recovered.

In the Lagrangian and Hamiltonian mechanics perspective, an alternative form, known as the multiplicative form, of the Lagrangian and Hamiltonian for the case of 1 variable were constructed. These Lagrangian and Hamiltonian come with a parameter and under the appropriate limit, the standard Lagrangian and Hamiltonian are recovered.

Apart from the entropy for quantifying the information, the Fisher information is another quantity that can be used, but with different aspect. In literature, there exist many extended Fisher information with one or many parameters. In this work, we construct another extended form of the Fisher information through the connection between the Fisher information and action functional together with the multiplicative form of the Lagrangian. Of course, this new Fisher information comes with a parameter and under appropriate limit, the standard Fisher information is recovered. Moreover, if one consider the infinite series with respect to the parameter, the Fisher information hierarchy is obtained. The standard Fisher information is the first one in the hierarchy. An interesting feature is that this new Fisher information can be mathematically expressed in the same form with the Tsallis entropy. However, the application of this new Fisher information is an open problem.

📌 Key results

– Given a construction of new types of Lagrangian and Hamiltonian with multi-parameters through the inverse problem of the calculus of variation.

– Given an overview of various entropies in literature.

– Give a new type of Fisher information called a one-parameter Fisher information for a system with one random variable and one estimated parameter. Furthermore, the mathematical structure and properties, which could be possibly connected to the Tsallis entropy, of this new Fisher information are noted.

📌 Journal :

https://link.springer.com/chapter/10.1007/978-981-19-0668-8_18

#IFTHEP #IFNU #PhysicsNaresuan